AI IN HET INFORMATIEDOMEIN (12) SIMON BEEN

Deel 12 artikelenserie over kunstmatige intelligentie

Simon Been

Directeur van het Papieren Tijger Netwerk en spreker/trainer/auteur over AI in het informatiedomein

Wat is de impact van AI op het informatiedomein? In een reeks artikelen wordt ingegaan op veranderingen in de organisatieprocessen, de informatieprofessie en het persoonlijke informatiewerk ten gevolge van kunstmatige intelligentie. Dit is het twaalfde deel dat inzoomt op de noodzaak van bewustwording van uitdagingen en oplossingsrichtingen rond generatieve AI.

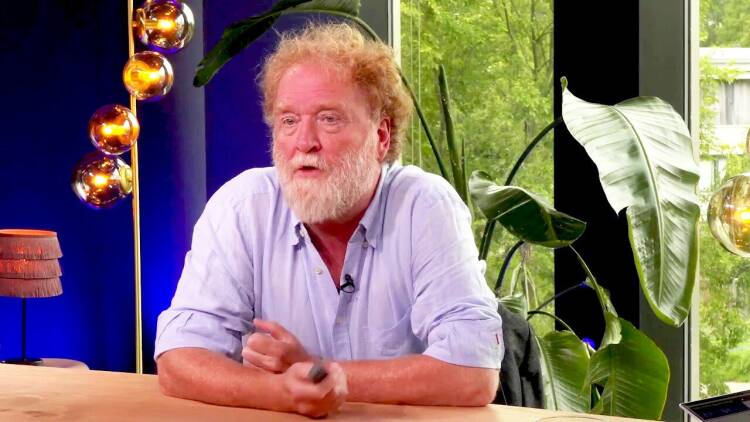

Onlangs vond in Den Haag een Heterdaadsessie van het Papieren Tijger Netwerk plaats –thema: de AI-impact op de informatiehuishouding. Verschillende sprekers schenen vanuit hun eigen organisatie en werkveld licht op dit onderwerp, onder wie Pim Haselager, AI-professor aan de Radboud Universiteit Nijmegen, en Saskia Lensink, product owner GPT-NL bij TNO. Beiden benadrukken het belang van verantwoord AI-gebruik, maar ieder vanuit een andere invalshoek. Haselager focust vooral op de maatschappelijke en ethische aspecten, Lensink meer op de onderliggende uitdagingen en lonkende maar complexe oplossingen, zoals de Nederlandse tegenhanger van ChatGPT: GPT-NL.

FUNDAMENTELE VERSCHUIVINGEN

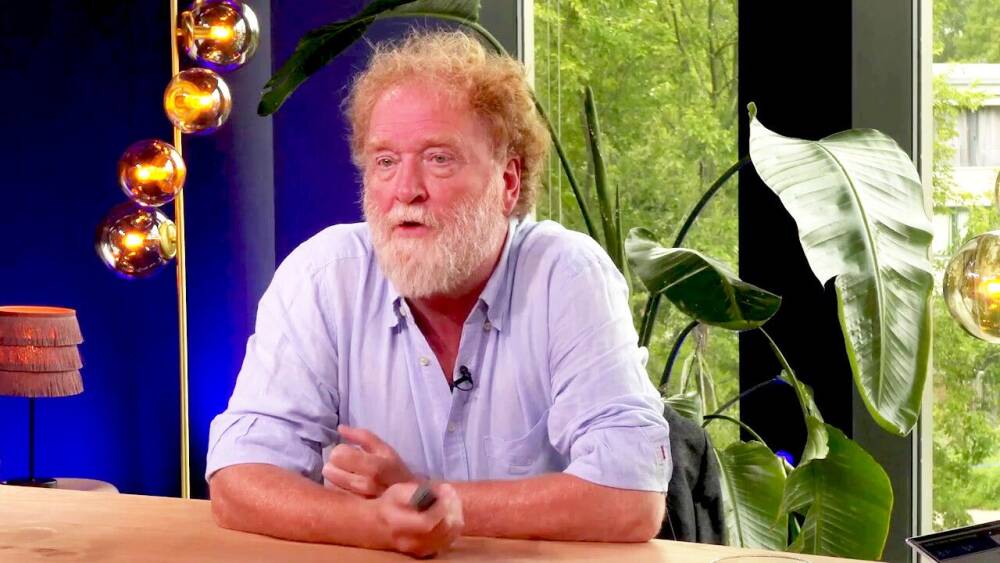

Hoogleraar Haselager, ook hoofdonderzoeker aan het Donders Institute for Brain, Cognition and Behaviour, richt zich vanuit zijn functie op de maatschappelijke implicaties van AI en cognitieve neurowetenschap. Hij neemt de aanwezigen mee in de mogelijkheden en zeker ook risico’s van AI met scherpe observaties, actuele voorbeelden en kritische reflecties. Stevige kritiek heeft hij op de focus van Silicon Valley op snelheid en disruptie, het ‘move fast and break things’, en hij prijst de Europese AI-regelgeving (AI Act). ‘Deze wet biedt een heldere definitie van AI als autonome, adaptieve systemen en benadrukt de noodzaak van ethisch verantwoord gebruik.’ Tegelijkertijd hekelt hij de praktische frustraties van regels zoals de General Data Protection Regulation (GDPR), bijvoorbeeld de overdaad aan ‘Klik OK’ als je sites wilt gebruiken.

Binnen zijn eigen vakgebied heeft hij met zijn onderzoeksgroep SIAC (Societal Implications of AI & Cognitive neuroscience) een masteropleiding opgezet die toekomstige beleidsadviseurs voorbereidt op verantwoord AI-gebruik. Hij waarschuwt dat de inzet van AI fundamentele verschuivingen veroorzaakt, ook in organisaties, met belangrijke consequenties voor verantwoordelijkheid en besluitvorming.

STEEDS COMPLEXERE SYSTEMEN

Haselager beschrijft hoe intelligentie, zowel natuurlijk als kunstmatig, voortkomt uit de behoefte om keuzes te maken in een fysieke omgeving. ‘Een plant kan niet bewegen dus heeft geen brein nodig.’ De indrukwekkende prestaties van kunstmatige intelligentie, zoals de verpletterende overwinning van AlphaGo Zero (autodidact) op AlphaGo (getraind op menselijke partijen), tonen aan dat menselijke intelligentie slechts een fractie is van wat mogelijk is. ‘We zien onszelf als het meest intelligent, maar dat is waarschijnlijk een illusie. Op verschillende deelgebieden kan AI ons ver overtreffen.’

Haselager waarschuwt dat AI-systemen steeds complexer worden en mogelijk oplossingen en redeneringen bieden die we niet meer begrijpen, wat grote uitdagingen creëert rondom verantwoordelijkheid en controle.

ETHICS WASHING EN DUURZAAMHEID

Technologie verzamelt big data die voor verwerking AI nodig hebben. Dat biedt veel mogelijkheden, bijvoorbeeld in de zorg. Tegelijkertijd roepen generatieve toepassingen zoals deepfakes, AI-muziek en andere content, zoals recentelijk een Coca-Cola-reclame (zie video links), volgens de hoogleraar fundamentele vragen op over copyright en menselijke creativiteit. Hij benadrukt nogmaals dat dergelijke technologieën risico’s met zich meebrengen, inclusief misbruik voor fake news of ethische kwesties rond ‘ethics washing’, waarbij bedrijven ethiek alleen gebruiken om bijvoorbeeld financiering te verkrijgen zonder echte betrokkenheid.

Haselager bespreekt meerdere praktische toepassingen van AI, zoals voorspellende systemen. In de VS gebruiken advocaten soms AI om te bepalen of een zaak kansrijk is, wat de toegang tot rechtspraak voor sommigen beperkt. Hij roept op tot kritisch nadenken hierover. Daarnaast belicht hij de milieu-impact van AI, bijvoorbeeld het waterverbruik van systemen zoals ChatGPT, en koppelt hij dit aan het belangrijke thema van duurzaamheid.

VERGELIJKING CIRKELZAAG

Haselager benadrukt dat de enorme potentie van AI gepaard gaat met risico’s. Hij vergelijkt de huidige situatie met ‘kinderen die met een cirkelzaag spelen’ en is voorstander van de Europese aanpak met zorgvuldige regulering en verantwoorde innovatie.

AI IS HIER EN NU

Saskia Lensink, product owner GPT-NL bij TNO, zit aanvankelijk op een vergelijkbaar spoor als ze ingaat op generative artificial intelligence (GenAI) en de impact op onze samenleving, economie en beroepspraktijk. Vervolgens focust ze op oplossingen. Haar werkgever TNO is een onafhankelijke kennispartner die met vele partners werkt op het snijvlak van wetenschap en praktijk, met als doel waarde toe te voegen aan de maatschappij. Generatieve AI ziet Lensink als een technologie die de wereld zoals wij die kennen transformeert. Het is niet langer een toekomstvisie; het is hier en nu. GenAI biedt enorme kansen. De geschatte economische waarde ervan wereldwijd bedraagt in 2030 maar liefst 111 miljard dollar, zo vertelt Lensink. ‘En 80 procent van alle bedrijfsprocessen zal in 2026 op de een of andere manier door GenAI worden beïnvloed.’ Dat zijn stevige cijfers.

Wat betekent dit in de praktijk? AI kan processen sneller en efficiënter maken, maar is ook een krachtige tool om innovatie te stimuleren. Denk aan de mogelijkheden om grote hoeveelheden data om te zetten in bruikbare inzichten, of aan GenAI-systemen die nieuwe creatieve oplossingen genereren. Tegelijkertijd vraagt deze technologie om een strategische aanpak en goed begrip van de toepassingen en implicaties. ‘We hebben de verantwoordelijkheid om niet alleen deze kansen te benutten, maar ook de uitdagingen die erbij komen kijken te adresseren.’

KADERS ZIJN NODIG

Generatieve AI maakt gebruik van krachtige modellen zoals foundation models en instruct models. Deze modellen stellen ons in staat om grote hoeveelheden ongestructureerde data om te zetten in bruikbare inzichten en innovatieve toepassingen. Denk aan geavanceerde tekst- en beeldgeneratie, of aan complexe analyses waarmee bedrijven sneller en efficiënter kunnen opereren. Maar deze technologie roept ook vragen op over de betrouwbaarheid van data, de ethiek van AI-gebruik en de controle over de uitkomsten. Het is van belang om deze vragen niet alleen te beantwoorden, maar ook om een kader te bieden waarin AI verantwoord kan worden ingezet. Dat is belangrijk omdat het niet helemaal duidelijk is hoe we het nou direct kunnen inzetten, wat het precies gaat betekenen en of het echt waarde toevoegt. Want, zoals Lensink zegt: ‘Er is ook een ongemak rondom AI. Er zijn zoveel vragen.’

ONGEMAK ROND AI

We zien bijvoorbeeld dat generatieve AI op grote schaal misinformatie kan produceren. Er zijn daarbij veel zorgen over de privacy van individuen. Neem de case van Jonathan Turley, hoogleraar Public Interest Law aan de George Washington University, die door ChatGPT in verband werd gebracht met sexual harassment. Het is behoorlijk vervelend als je naam wordt genoemd door een AI die beweert dat jij iets hebt gedaan waar je helemaal niets vanaf weet.

Echt alle grote modellen zijn getraind op heel grote datasets waar copyrights op zitten. Er worden massaal data gestolen. Er zijn heel veel privacyschendingen. De topman van OpenAI heeft echter beweerd over het trainen zonder copyright en zonder toestemming van creators en auteurs: ‘Wij kunnen niet innoveren zonder die data. Onmogelijk. Kan niet anders.’ Ook daar voelen we ons best ongemakkelijk bij. Hoe gaan we daarmee om?

TOENAME UITSTOOT

En dan dit: er wordt ongelofelijk veel uitstoot veroorzaakt bij het trainen van AI-modellen, maar ook bij het inzetten ervan, want als ze helemaal zijn getraind gebruiken we ze ook. We weten: als je een vraag stelt aan ChatGPT, veroorzaakt dat ongeveer 21 keer zoveel uitstoot als wanneer je diezelfde vraag aan Google stelt. Dat is dus eveneens iets om in gedachten te houden.

De bigtechreuzen hebben op dit moment op grote schaal energiecontracten voor langere termijn afgesloten met elektriciteitsleveranciers, en Google heeft daarnaast een aantal kerncentrales aangekocht. Men verwacht dus dat ook in de toekomst flink wat energie nodig gaat zijn om al die AI-applicaties mogelijk te maken. Ook daar voelen we ongemak bij met ons allen.

EEN ALTERNATIEF: GPT-NL

Een van de dingen waar Lensink met TNO veel mee bezig is: hoe kunnen we een alternatief bouwen voor alle grote taalmodellen van big tech waarin we ons wél aan de wet houden? En dus vanaf de start netjes data-afspraken maken met datahouders en de privacy respecteren van de individuen die worden genoemd, inclusief afspraken met creatieve creators? Op de site van GPT-NL staat hierover:

We ontwikkelen een taalmodel voor de Nederlandse taal en cultuur. Transparant, inclusief en volgens Nederlandse en Europese waarden, en we zullen open over de beslissingen en afwegingen communiceren.

GPT-NL wordt een transparant taalmodel. Dat betekent dat we transparant zijn over de keuzes die tijdens de datacuratie en het trainingsproces worden gemaakt. Hiermee houden we ook expliciet rekening met uitdagingen rondom vooroordelen, bias en ethische kaders. Zo draagt GPT-NL bij aan meer openheid, transparantie en bescherming van de dataprivacy van gebruikers.

De ontwikkeling van GPT-NL gebeurt in lijn met de Algemene verordening gegevensbescherming (AVG) en de AI Act om tot een model te komen dat niet is getraind op bronnen die privacy- of IP-rechten schenden. We zullen state-of-the-art modelarchitectuur hergebruiken, maar de training zelf doen we helemaal from scratch om te voorkomen dat er onbekende factoren van eerdere modellen worden geërfd, zoals copyrightschendingen of het onrechtmatig gebruikmaken van persoonsgegevens. Door al onze data zelf te verzamelen, gesprekken aan te gaan met datahouders en een zorgvuldig proces te waarborgen, verkleinen we de kans op inbreuk van rechten van derden en hopen we een inspiratie te zijn voor andere initiatieven – innoveren met generatieve AI zonder op grote schaal de wet te overtreden.

Als product owner GPT-NL bij TNO zit Lensink hier middenin. Het lastige is, zo zegt ze: ‘Dat vergt heel veel data. We hopen dat we in april 2025 kunnen beginnen met trainen, maar het krijgen van voldoende data om een model te maken waar je wat aan hebt, is een enorme uitdaging.’

FORSE UITDAGINGEN

Ze constateert vier forse uitdagingen als het gaat om die data. ‘Als je zo’n groot model off the shelf ergens inzet, werkt het niet zomaar in één keer goed. Je moet het aan je eigen context gaan aanpassen. Dat is wel een hobbel. Kunnen we daar misschien het een of ander in faciliteren? Je hebt context nodig. Je moet snappen waar je het voor inzet. En het model moet heel goed begrijpen in welke context jij het wilt gaan gebruiken. Een tweede uitdaging is met name de herkomst van die data. Waar trainen we het model op? Kunnen we dat netjes doen?’

Een derde uitdaging waar Lensink zich nog veel zorgen over maakt, is dat je allemaal wet- en regelgeving hebt, maar ook waarden en normen. En je zou ook heel graag willen voorkomen dat zo’n model dingen gaat roepen die ‘onmenselijk’ zijn, of die buiten je eigen kaders vallen. Dat vergt dus innovatie om de techniek een beetje in bedwang te houden. TNO is van de technische oplossingen, maar merkt ook dat een van de grootste uitdagingen niet alleen de technische, maar juist ook die sociale en juridische kant is. Lukt het om dat te laten samenkomen?

LOKALE, KLEINE MODELLEN

De laatste uitdaging die ze noemt betreft het duurzaamheidsvraagstuk. We weten dat AI-modellen heel veel energie kosten, en ook dat het nieuw opbouwen ervan heel energie-intensief is. Kunnen we dat slimmer en zuiniger doen met elkaar? Kunnen we wellicht kleinere modellen maken die we bijvoorbeeld in de eigen lokale omgeving draaien zonder dat we per se een clouddienst hoeven af te nemen? Want ook daarvan kunnen we, op het moment dat er een abonnement bij een groot platform wordt afgesloten, de kosten wel doorrekenen: die gaan de komende jaren flink omhoog. Qua kosten en uitgaven heeft AI dus eveneens consequenties. Misschien kan er worden toegewerkt naar lokale modellen die kleiner zijn en die op de lange termijn ook een stuk goedkoper zullen zijn.

Lensink pretendeert niet al te weten hoe met dergelijke vraagstukken om te gaan. Sterker nog: ‘Daar hebben we allemaal nog geen antwoord op, maar we zijn er druk mee bezig.’ Tussen de regels door klinkt twijfel over de haalbaarheid van deze missie. We weten immers dat wetten en actoren (zoals de Autoriteit Persoonsgegevens) weinig bewegingsruimte bieden en dat de technologie nu eenmaal niet onfeilbaar is. Bovendien: wat zijn precies die Nederlandse en Europese waarden?

VOORLOPIG GEEN SILVER BULLETS

Haar inzicht: large language models zijn geen silver bullets. Ze kunnen veel, maar zijn geen fantastische oplossing voor alles. 'Je moet heel goed nadenken over hoe je ze wilt inzetten, en waar, en je moet ze heel erg richten op jouw specifieke behoeftes. Er moet een systeem worden gevonden, met meerdere disciplines bij elkaar, om er zoveel mogelijk waarde uit te halen. Dan is de vraag: hoe gebruikt iedereen het, waar liggen de behoeftes, waar de uitdagingen? Dat bepaalt wat nodig is om de volgende stap te kunnen zetten.'

We zijn met elkaar pioniers in het wilde westen van AI. Het is soms wel fijn om te beseffen dat ook een hoogleraar en een GPT-expert tegen de grenzen van kennis en mogelijkheden aanlopen. De boodschap is duidelijk: generatieve AI biedt enorme kansen, maar zonder samenwerking, kritisch denken en een stevige, maar niet te knellende, ethische en juridische basis riskeren we dat de technologie meer schade aanricht dan vooruitgang boekt. Het informatiedomein staat daarmee voor een uitdagende, maar ook inspirerende reis naar een toekomst waarin AI en menselijke waarden hand in hand moeten gaan.

WAT KUN JE ZELF DOEN?

Dit alles begint met een heel persoonlijke bewustwording, niet alleen bij de experts, maar vooral ook bij de mensen die uiteindelijk ermee te maken hebben als gebruiker, als werknemer, als burger en als hoeder van het informatiedomein. Je kent mijn oproep wellicht al wel: beperk je niet tot lezen en luisteren, maar ga zelf ermee aan de slag. Hands-on, zet door, vorm je eigen mening en zorg dat je ‘AI-geletterd’ bent – dat is per 2 februari 2025 ook nog eens verplicht. <

Met meer bordconfiguraties dan er atomen in het universum zijn, wordt het oude Chinese spel Go al lange tijd beschouwd als een grote uitdaging voor kunstmatige intelligentie. Op 9 maart 2016 stonden de werelden van Go en AI tegenover elkaar tijdens The DeepMind Challenge Match. Honderden miljoenen mensen over de hele wereld keken toe hoe een Go-meester voor het eerst in de geschiedenis het opnam tegen een onbewezen AI-uitdager (AlphaGo) – de laatste won. Er verscheen in 2017 een documentaire over, die vele prijzen won. De film is te bekijken via alphagomovie.com. (Later zou de autodidacte AI AlphaGo Zero het nog eens dunnetjes overdoen en AlphaGo verslaan.)

De AI-remake van de Coca-Cola-kerstcommercial uit 1995 (‘The holidays are coming’), met als pay-off ‘Real Magic’, schoot bij veel consumenten in het verkeerde keelgat.

‘Aanbieders en gebruiksverantwoordelijken van AI-systemen nemen maatregelen om, zoveel als mogelijk, te zorgen voor een toereikend niveau van AI-geletterdheid bij hun personeel en andere personen die namens hen AI-systemen exploiteren en gebruiken, en houden daarbij rekening met hun technische kennis, ervaring, onderwijs en opleiding en de context waarin de AI-systemen zullen worden gebruikt, evenals met de personen of groepen personen ten aanzien van wie de AI-systemen zullen worden gebruikt.’

Artikel 4 van de

AI Act (AI-verordening):

AI-geletterdheid

De lijst is vele malen langer. Wil je weten hoeveel AI-tools er intussen zijn en wat die kunnen, check dan There’s An AI For That (TAAFT) voor een overzicht. Of kijk op AI Search.

OVERZICHT(JE) VAN CHATBOTS

> ChatGPT

> Google Gemini

> Meta AI

> HuggingChat (open source)

> Zapier AI Chatbot

> Microsoft Copilot (met Bing)

> Perplexity

> YouChat

> KoalaChat

> Jasper Chat

> MetaGPT

> Claude

> Ernie Bot

> Bloom

> Character.ai

‘Intelligentie, zowel natuurlijk als kunstmatig, komt voort uit de behoefte om keuzes te maken in een fysieke omgeving‘

‘We zien onszelf als het meest intelligent, maar dat is een illusie. Op verschillende deelgebieden kan AI ons ver overtreffen‘

‘Bij ethics washing gebruiken bedrijven ethiek alleen om bijvoorbeeld financiering te verkrijgen zonder echte betrokkenheid‘

‘De bigtechreuzen hebben op grote schaal energiecontracten voor langere termijn afgesloten met elektriciteitsleveranciers‘

‘We hopen in april te beginnen met trainen, maar het krijgen van voldoende data voor het model is een enorme uitdaging‘

‘Het informatiedomein staat voor een inspirerende reis naar een toekomst waarin AI en menselijke waarden hand in hand moeten gaan‘

DE VOORGAANDE DELEN

VAN DEZE SERIE LEZEN?

Je vindt ze in het online archief

op informatieprofessional.nl.

> DEEL 1

> DEEL 2

> DEEL 3

> DEEL 4

> DEEL 5

> DEEL 6

> DEEL 7

> DEEL 8

> DEEL 9

> DEEL 10

> DEEL 11

IP | vakblad voor informatieprofessionals | 09 / 2024

Saskia Lensink

Pim Haselager tijdens een webinar over neurotechnologie bij de RijksAcademie voor Digitalisering en Informatisering Overheid (RADIO).

AI IN HET INFORMATIEDOMEIN (12) SIMON BEEN

Deel 12 artikelenserie over kunstmatige intelligentie

Wat is de impact van AI op het informatiedomein? In een reeks artikelen wordt ingegaan op veranderingen in de organisatieprocessen, de informatieprofessie en het persoonlijke informatiewerk ten gevolge van kunstmatige intelligentie. Dit is het twaalfde deel dat inzoomt op de noodzaak van bewustwording van uitdagingen en oplossingsrichtingen rond generatieve AI.

Simon Been

Directeur van het Papieren Tijger Netwerk en spreker/trainer/auteur over AI in het informatiedomein

Pim Haselager tijdens een webinar over neurotechnologie bij de RijksAcademie voor Digitalisering en Informatisering Overheid (RADIO).

Saskia Lensink

Onlangs vond in Den Haag een Heterdaadsessie van het Papieren Tijger Netwerk plaats –thema: de AI-impact op de informatiehuishouding. Verschillende sprekers schenen vanuit hun eigen organisatie en werkveld licht op dit onderwerp, onder wie Pim Haselager, AI-professor aan de Radboud Universiteit Nijmegen, en Saskia Lensink, product owner GPT-NL bij TNO. Beiden benadrukken het belang van verantwoord AI-gebruik, maar ieder vanuit een andere invalshoek. Haselager focust vooral op de maatschappelijke en ethische aspecten, Lensink meer op de onderliggende uitdagingen en lonkende maar complexe oplossingen, zoals de Nederlandse tegenhanger van ChatGPT: GPT-NL.

FUNDAMENTELE VERSCHUIVINGEN

Hoogleraar Haselager, ook hoofdonderzoeker aan het Donders Institute for Brain, Cognition and Behaviour, richt zich vanuit zijn functie op de maatschappelijke implicaties van AI en cognitieve neurowetenschap. Hij neemt de aanwezigen mee in de mogelijkheden en zeker ook risico’s van AI met scherpe observaties, actuele voorbeelden en kritische reflecties. Stevige kritiek heeft hij op de focus van Silicon Valley op snelheid en disruptie, het ‘move fast and break things’, en hij prijst de Europese AI-regelgeving (AI Act). ‘Deze wet biedt een heldere definitie van AI als autonome, adaptieve systemen en benadrukt de noodzaak van ethisch verantwoord gebruik.’ Tegelijkertijd hekelt hij de praktische frustraties van regels zoals de General Data Protection Regulation (GDPR), bijvoorbeeld de overdaad aan ‘Klik OK’ als je sites wilt gebruiken.

Binnen zijn eigen vakgebied heeft hij met zijn onderzoeksgroep SIAC (Societal Implications of AI & Cognitive neuroscience) een masteropleiding opgezet die toekomstige beleidsadviseurs voorbereidt op verantwoord AI-gebruik. Hij waarschuwt dat de inzet van AI fundamentele verschuivingen veroorzaakt, ook in organisaties, met belangrijke consequenties voor verantwoordelijkheid en besluitvorming.

STEEDS COMPLEXERE SYSTEMEN

Haselager beschrijft hoe intelligentie, zowel natuurlijk als kunstmatig, voortkomt uit de behoefte om keuzes te maken in een fysieke omgeving. ‘Een plant kan niet bewegen dus heeft geen brein nodig.’ De indrukwekkende prestaties van kunstmatige intelligentie, zoals de verpletterende overwinning van AlphaGo Zero (autodidact) op AlphaGo (getraind op menselijke partijen), tonen aan dat menselijke intelligentie slechts een fractie is van wat mogelijk is. ‘We zien onszelf als het meest intelligent, maar dat is waarschijnlijk een illusie. Op verschillende deelgebieden kan AI ons ver overtreffen.’

Haselager waarschuwt dat AI-systemen steeds complexer worden en mogelijk oplossingen en redeneringen bieden die we niet meer begrijpen, wat grote uitdagingen creëert rondom verantwoordelijkheid en controle.

ETHICS WASHING EN DUURZAAMHEID

Technologie verzamelt big data die voor verwerking AI nodig hebben. Dat biedt veel mogelijkheden, bijvoorbeeld in de zorg. Tegelijkertijd roepen generatieve toepassingen zoals deepfakes, AI-muziek en andere content, zoals recentelijk een Coca-Cola-reclame (zie video links), volgens de hoogleraar fundamentele vragen op over copyright en menselijke creativiteit. Hij benadrukt nogmaals dat dergelijke technologieën risico’s met zich meebrengen, inclusief misbruik voor fake news of ethische kwesties rond ‘ethics washing’, waarbij bedrijven ethiek alleen gebruiken om bijvoorbeeld financiering te verkrijgen zonder echte betrokkenheid.

Haselager bespreekt meerdere praktische toepassingen van AI, zoals voorspellende systemen. In de VS gebruiken advocaten soms AI om te bepalen of een zaak kansrijk is, wat de toegang tot rechtspraak voor sommigen beperkt. Hij roept op tot kritisch nadenken hierover. Daarnaast belicht hij de milieu-impact van AI, bijvoorbeeld het waterverbruik van systemen zoals ChatGPT, en koppelt hij dit aan het belangrijke thema van duurzaamheid.

VERGELIJKING CIRKELZAAG

Haselager benadrukt dat de enorme potentie van AI gepaard gaat met risico’s. Hij vergelijkt de huidige situatie met ‘kinderen die met een cirkelzaag spelen’ en is voorstander van de Europese aanpak met zorgvuldige regulering en verantwoorde innovatie.

AI IS HIER EN NU

Saskia Lensink, product owner GPT-NL bij TNO, zit aanvankelijk op een vergelijkbaar spoor als ze ingaat op generative artificial intelligence (GenAI) en de impact op onze samenleving, economie en beroepspraktijk. Vervolgens focust ze op oplossingen. Haar werkgever TNO is een onafhankelijke kennispartner die met vele partners werkt op het snijvlak van wetenschap en praktijk, met als doel waarde toe te voegen aan de maatschappij. Generatieve AI ziet Lensink als een technologie die de wereld zoals wij die kennen transformeert. Het is niet langer een toekomstvisie; het is hier en nu. GenAI biedt enorme kansen. De geschatte economische waarde ervan wereldwijd bedraagt in 2030 maar liefst 111 miljard dollar, zo vertelt Lensink. ‘En 80 procent van alle bedrijfsprocessen zal in 2026 op de een of andere manier door GenAI worden beïnvloed.’ Dat zijn stevige cijfers.

Wat betekent dit in de praktijk? AI kan processen sneller en efficiënter maken, maar is ook een krachtige tool om innovatie te stimuleren. Denk aan de mogelijkheden om grote hoeveelheden data om te zetten in bruikbare inzichten, of aan GenAI-systemen die nieuwe creatieve oplossingen genereren. Tegelijkertijd vraagt deze technologie om een strategische aanpak en goed begrip van de toepassingen en implicaties. ‘We hebben de verantwoordelijkheid om niet alleen deze kansen te benutten, maar ook de uitdagingen die erbij komen kijken te adresseren.’

KADERS ZIJN NODIG

Generatieve AI maakt gebruik van krachtige modellen zoals foundation models en instruct models. Deze modellen stellen ons in staat om grote hoeveelheden ongestructureerde data om te zetten in bruikbare inzichten en innovatieve toepassingen. Denk aan geavanceerde tekst- en beeldgeneratie, of aan complexe analyses waarmee bedrijven sneller en efficiënter kunnen opereren. Maar deze technologie roept ook vragen op over de betrouwbaarheid van data, de ethiek van AI-gebruik en de controle over de uitkomsten. Het is van belang om deze vragen niet alleen te beantwoorden, maar ook om een kader te bieden waarin AI verantwoord kan worden ingezet. Dat is belangrijk omdat het niet helemaal duidelijk is hoe we het nou direct kunnen inzetten, wat het precies gaat betekenen en of het echt waarde toevoegt. Want, zoals Lensink zegt: ‘Er is ook een ongemak rondom AI. Er zijn zoveel vragen.’

ONGEMAK ROND AI

We zien bijvoorbeeld dat generatieve AI op grote schaal misinformatie kan produceren. Er zijn daarbij veel zorgen over de privacy van individuen. Neem de case van Jonathan Turley, hoogleraar Public Interest Law aan de George Washington University, die door ChatGPT in verband werd gebracht met sexual harassment. Het is behoorlijk vervelend als je naam wordt genoemd door een AI die beweert dat jij iets hebt gedaan waar je helemaal niets vanaf weet.

Echt alle grote modellen zijn getraind op heel grote datasets waar copyrights op zitten. Er worden massaal data gestolen. Er zijn heel veel privacyschendingen. De topman van OpenAI heeft echter beweerd over het trainen zonder copyright en zonder toestemming van creators en auteurs: ‘Wij kunnen niet innoveren zonder die data. Onmogelijk. Kan niet anders.’ Ook daar voelen we ons best ongemakkelijk bij. Hoe gaan we daarmee om?

TOENAME UITSTOOT

En dan dit: er wordt ongelofelijk veel uitstoot veroorzaakt bij het trainen van AI-modellen, maar ook bij het inzetten ervan, want als ze helemaal zijn getraind gebruiken we ze ook. We weten: als je een vraag stelt aan ChatGPT, veroorzaakt dat ongeveer 21 keer zoveel uitstoot als wanneer je diezelfde vraag aan Google stelt. Dat is dus eveneens iets om in gedachten te houden.

De bigtechreuzen hebben op dit moment op grote schaal energiecontracten voor langere termijn afgesloten met elektriciteitsleveranciers, en Google heeft daarnaast een aantal kerncentrales aangekocht. Men verwacht dus dat ook in de toekomst flink wat energie nodig gaat zijn om al die AI-applicaties mogelijk te maken. Ook daar voelen we ongemak bij met ons allen.

EEN ALTERNATIEF: GPT-NL

Een van de dingen waar Lensink met TNO veel mee bezig is: hoe kunnen we een alternatief bouwen voor alle grote taalmodellen van big tech waarin we ons wél aan de wet houden? En dus vanaf de start netjes data-afspraken maken met datahouders en de privacy respecteren van de individuen die worden genoemd, inclusief afspraken met creatieve creators? Op de site van GPT-NL staat hierover:

We ontwikkelen een taalmodel voor de Nederlandse taal en cultuur. Transparant, inclusief en volgens Nederlandse en Europese waarden, en we zullen open over de beslissingen en afwegingen communiceren.

GPT-NL wordt een transparant taalmodel. Dat betekent dat we transparant zijn over de keuzes die tijdens de datacuratie en het trainingsproces worden gemaakt. Hiermee houden we ook expliciet rekening met uitdagingen rondom vooroordelen, bias en ethische kaders. Zo draagt GPT-NL bij aan meer openheid, transparantie en bescherming van de dataprivacy van gebruikers.

De ontwikkeling van GPT-NL gebeurt in lijn met de Algemene verordening gegevensbescherming (AVG) en de AI Act om tot een model te komen dat niet is getraind op bronnen die privacy- of IP-rechten schenden. We zullen state-of-the-art modelarchitectuur hergebruiken, maar de training zelf doen we helemaal from scratch om te voorkomen dat er onbekende factoren van eerdere modellen worden geërfd, zoals copyrightschendingen of het onrechtmatig gebruikmaken van persoonsgegevens. Door al onze data zelf te verzamelen, gesprekken aan te gaan met datahouders en een zorgvuldig proces te waarborgen, verkleinen we de kans op inbreuk van rechten van derden en hopen we een inspiratie te zijn voor andere initiatieven – innoveren met generatieve AI zonder op grote schaal de wet te overtreden.

Als product owner GPT-NL bij TNO zit Lensink hier middenin. Het lastige is, zo zegt ze: ‘Dat vergt heel veel data. We hopen dat we in april 2025 kunnen beginnen met trainen, maar het krijgen van voldoende data om een model te maken waar je wat aan hebt, is een enorme uitdaging.’

FORSE UITDAGINGEN

Ze constateert vier forse uitdagingen als het gaat om die data. ‘Als je zo’n groot model off the shelf ergens inzet, werkt het niet zomaar in één keer goed. Je moet het aan je eigen context gaan aanpassen. Dat is wel een hobbel. Kunnen we daar misschien het een of ander in faciliteren? Je hebt context nodig. Je moet snappen waar je het voor inzet. En het model moet heel goed begrijpen in welke context jij het wilt gaan gebruiken. Een tweede uitdaging is met name de herkomst van die data. Waar trainen we het model op? Kunnen we dat netjes doen?’

Een derde uitdaging waar Lensink zich nog veel zorgen over maakt, is dat je allemaal wet- en regelgeving hebt, maar ook waarden en normen. En je zou ook heel graag willen voorkomen dat zo’n model dingen gaat roepen die ‘onmenselijk’ zijn, of die buiten je eigen kaders vallen. Dat vergt dus innovatie om de techniek een beetje in bedwang te houden. TNO is van de technische oplossingen, maar merkt ook dat een van de grootste uitdagingen niet alleen de technische, maar juist ook die sociale en juridische kant is. Lukt het om dat te laten samenkomen?

LOKALE, KLEINE MODELLEN

De laatste uitdaging die ze noemt betreft het duurzaamheidsvraagstuk. We weten dat AI-modellen heel veel energie kosten, en ook dat het nieuw opbouwen ervan heel energie-intensief is. Kunnen we dat slimmer en zuiniger doen met elkaar? Kunnen we wellicht kleinere modellen maken die we bijvoorbeeld in de eigen lokale omgeving draaien zonder dat we per se een clouddienst hoeven af te nemen? Want ook daarvan kunnen we, op het moment dat er een abonnement bij een groot platform wordt afgesloten, de kosten wel doorrekenen: die gaan de komende jaren flink omhoog. Qua kosten en uitgaven heeft AI dus eveneens consequenties. Misschien kan er worden toegewerkt naar lokale modellen die kleiner zijn en die op de lange termijn ook een stuk goedkoper zullen zijn.

Lensink pretendeert niet al te weten hoe met dergelijke vraagstukken om te gaan. Sterker nog: ‘Daar hebben we allemaal nog geen antwoord op, maar we zijn er druk mee bezig.’ Tussen de regels door klinkt twijfel over de haalbaarheid van deze missie. We weten immers dat wetten en actoren (zoals de Autoriteit Persoonsgegevens) weinig bewegingsruimte bieden en dat de technologie nu eenmaal niet onfeilbaar is. Bovendien: wat zijn precies die Nederlandse en Europese waarden?

VOORLOPIG GEEN SILVER BULLETS

Haar inzicht: large language models zijn geen silver bullets. Ze kunnen veel, maar zijn geen fantastische oplossing voor alles. 'Je moet heel goed nadenken over hoe je ze wilt inzetten, en waar, en je moet ze heel erg richten op jouw specifieke behoeftes. Er moet een systeem worden gevonden, met meerdere disciplines bij elkaar, om er zoveel mogelijk waarde uit te halen. Dan is de vraag: hoe gebruikt iedereen het, waar liggen de behoeftes, waar de uitdagingen? Dat bepaalt wat nodig is om de volgende stap te kunnen zetten.'

We zijn met elkaar pioniers in het wilde westen van AI. Het is soms wel fijn om te beseffen dat ook een hoogleraar en een GPT-expert tegen de grenzen van kennis en mogelijkheden aanlopen. De boodschap is duidelijk: generatieve AI biedt enorme kansen, maar zonder samenwerking, kritisch denken en een stevige, maar niet te knellende, ethische en juridische basis riskeren we dat de technologie meer schade aanricht dan vooruitgang boekt. Het informatiedomein staat daarmee voor een uitdagende, maar ook inspirerende reis naar een toekomst waarin AI en menselijke waarden hand in hand moeten gaan.

WAT KUN JE ZELF DOEN?

Dit alles begint met een heel persoonlijke bewustwording, niet alleen bij de experts, maar vooral ook bij de mensen die uiteindelijk ermee te maken hebben als gebruiker, als werknemer, als burger en als hoeder van het informatiedomein. Je kent mijn oproep wellicht al wel: beperk je niet tot lezen en luisteren, maar ga zelf ermee aan de slag. Hands-on, zet door, vorm je eigen mening en zorg dat je ‘AI-geletterd’ bent – dat is per 2 februari 2025 ook nog eens verplicht. <

De AI-remake van de Coca-Cola-kerstcommercial uit 1995 (‘The holidays are coming’), met als pay-off ‘Real Magic’, schoot bij veel consumenten in het verkeerde keelgat.

Met meer bordconfiguraties dan er atomen in het universum zijn, wordt het oude Chinese spel Go al lange tijd beschouwd als een grote uitdaging voor kunstmatige intelligentie. Op 9 maart 2016 stonden de werelden van Go en AI tegenover elkaar tijdens The DeepMind Challenge Match. Honderden miljoenen mensen over de hele wereld keken toe hoe een Go-meester voor het eerst in de geschiedenis het opnam tegen een onbewezen AI-uitdager (AlphaGo) – de laatste won. Er verscheen in 2017 een documentaire over, die vele prijzen won. De film is te bekijken via alphagomovie.com. (Later zou de autodidacte AI AlphaGo Zero het nog eens dunnetjes overdoen en AlphaGo verslaan.)

‘Aanbieders en gebruiksverantwoordelijken van AI-systemen nemen maatregelen om, zoveel als mogelijk, te zorgen voor een toereikend niveau van AI-geletterdheid bij hun personeel en andere personen die namens hen AI-systemen exploiteren en gebruiken, en houden daarbij rekening met hun technische kennis, ervaring, onderwijs en opleiding en de context waarin de AI-systemen zullen worden gebruikt, evenals met de personen of groepen personen ten aanzien van wie de AI-systemen zullen worden gebruikt.’

Artikel 4 van de

AI Act (AI-verordening):

AI-geletterdheid

De lijst is vele malen langer. Wil je weten hoeveel AI-tools er intussen zijn en wat die kunnen, check dan There’s An AI For That (TAAFT) voor een overzicht. Of kijk op AI Search.

OVERZICHT(JE) VAN CHATBOTS

> ChatGPT

> Google Gemini

> Meta AI

> HuggingChat (open source)

> Zapier AI Chatbot

> Microsoft Copilot (met Bing)

> Perplexity

> YouChat

> KoalaChat

> Jasper Chat

> MetaGPT

> Claude

> Ernie Bot

> Bloom

> Character.ai

DE VOORGAANDE DELEN

VAN DEZE SERIE LEZEN?

Je vindt ze in het online archief

op informatieprofessional.nl.

> DEEL 1

> DEEL 2

> DEEL 3

> DEEL 4

> DEEL 5

> DEEL 6

> DEEL 7

> DEEL 8

> DEEL 9

> DEEL 10

> DEEL 11

IP | vakblad voor informatieprofessionals | 09 / 2024